在当前人工智能技术日新月异的时代,语言模型的应用已经渗透到各行各业,而随着AI应用的普及,如何有效地管理和操作这些强大的模型成为了一项关键挑战。LangFlow正是为了解决这一难题而诞生的开源项目,它为开发者提供了一个易于使用、功能强大的平台,用于构建、管理和操作基于大语言模型(LLM)的系统。

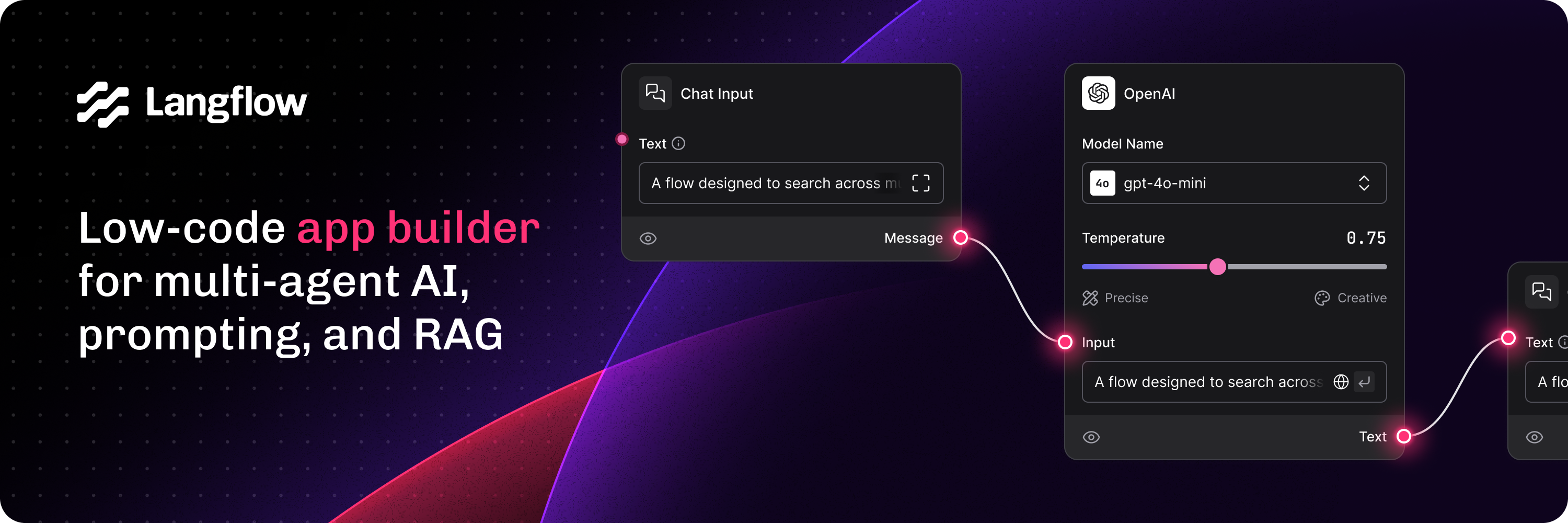

LangFlow的独特之处在于其简化了复杂模型的集成与应用,允许用户通过低代码甚至零代码的方式,快速构建并部署自定义的语言模型应用。其独特的工作流设计,使得开发者能够轻松地将不同的AI组件结合起来,从而满足复杂的业务需求。无论是简单的聊天机器人,还是复杂的多步骤推理任务,LangFlow都能提供高效的支持。我们将深入探讨LangFlow的功能特色以及如何使用这个开源项目来提升自己的开发效率和应用能力。

一、LangFlow项目背景

随着大语言模型的普及,越来越多的开发者和企业开始意识到,直接与模型交互并不容易。传统的API调用、数据传递、模型调优等操作都需要开发者具备一定的技术基础,并且开发过程繁琐且容易出错。LangFlow通过构建一个清晰、模块化的工作流框架,简化了这些操作,使得开发者能够在可视化的界面中轻松设计、调度和调优语言模型的工作流程,从而提升开发效率并降低出错率。

LangFlow源自于Python语言生态中的一些热门工具,结合了机器学习、自然语言处理(NLP)以及自动化工作流的优势,使得开发者可以通过图形化界面快速构建AI应用,而无需深入编写复杂的代码。借助这一工具,用户可以在不牺牲灵活性的前提下,快速实现对大语言模型的深度定制。

二、LangFlow的功能特点

-

模块化的工作流设计

LangFlow最突出的特点就是其模块化的工作流设计。用户可以通过将不同的模块(如数据输入、模型调用、数据处理、输出结果等)进行串联,构建一个完整的AI应用工作流。每个模块都可以通过简单的拖拽进行配置,无需编写大量代码。这种模块化的方式极大地提高了工作流的可维护性和可扩展性,开发者可以根据实际需求自由组合不同的模块,灵活调整系统架构。

-

无缝集成多种大语言模型

由于LangFlow支持与多种主流的语言模型和AI平台无缝集成,开发者可以轻松使用如OpenAI、Hugging Face、LLama等多个语言模型,无论是文本生成、情感分析、翻译还是其他复杂的任务,都可以通过LangFlow进行快速调用。这种集成方式为开发者提供了极大的灵活性,可以根据业务需求选择最适合的模型,而无需重新编写复杂的代码。

-

图形化界面和可视化操作

LangFlow的图形化界面是其一大亮点。开发者无需深厚的编程基础即可通过简单的可视化操作,创建和调试整个AI应用的工作流。每个模块的配置、参数设置等操作都可以通过图形化界面完成,极大降低了AI应用开发的门槛。用户也可以实时查看工作流的执行状态和日志,方便进行调试和优化。

-

低代码支持

对于有一定编程基础的开发者,LangFlow提供了低代码的支持。用户可以在图形化界面的基础上,插入自定义代码模块,来处理一些复杂的逻辑或需求。通过这种方式,开发者既可以享受图形化界面带来的便捷,又能够在特定的模块中进行深度定制,满足个性化的应用需求。

-

灵活的数据处理功能

数据处理是语言模型应用中的关键环节之一。LangFlow提供了强大的数据处理功能,包括文本预处理、清洗、特征提取等。用户可以在工作流中灵活地配置数据处理模块,使得输入数据能够准确地符合模型的要求。这些功能极大地增强了LangFlow的适应性,用户可以根据具体的数据特点灵活调整处理流程,保证模型的输入数据质量。

-

自动化任务调度与管理

对于需要定期更新或者重复执行的任务,LangFlow提供了自动化的任务调度功能。用户可以设置任务的执行周期、优先级、输入输出等参数,使得模型的调用过程更加高效和自动化。这一功能对于大规模的语言模型应用场景尤为重要,能够有效减少人工干预,提高系统的自动化程度和可靠性。

-

社区支持与开源精神

作为一个开源项目,LangFlow拥有广泛的社区支持。开发者不仅可以使用这个工具,还可以参与到项目的贡献中,为其发展提供自己的想法和代码。这种开源精神不仅促进了项目的快速发展,也使得LangFlow能够不断吸收用户的反馈,优化和改进自身的功能。用户可以通过GitHub等平台获取最新版本,并参与到项目的协作中去。

三、LangFlow的使用方法

-

安装LangFlow

LangFlow的安装过程相对简单,开发者只需通过pip命令即可完成安装。在命令行中执行以下命令:

pip install langflow

安装完成后,用户可以通过命令行或者集成开发环境(IDE)启动LangFlow,开始构建自己的工作流应用。

-

创建和配置工作流

启动LangFlow后,用户可以进入到图形化界面,选择“新建工作流”选项。在工作流设计界面中,用户可以根据需求添加不同的模块,例如数据输入、模型调用、数据处理、结果输出等。每个模块的设置都可以通过点击并填写相应的参数来完成。通过简单的拖拽,用户可以将各个模块连接起来,形成一个完整的工作流。

-

选择模型和任务配置

在工作流设计过程中,用户可以选择自己所需要的语言模型。LangFlow提供了与多个主流模型平台的集成接口,用户可以根据实际需要选择OpenAI、Hugging Face等模型平台,配置API密钥和模型参数。选择模型后,用户可以设置任务参数,例如文本生成的长度、温度、推理速度等,以确保模型的输出符合需求。

-

数据输入与输出配置

数据输入是构建工作流的一个重要环节。在LangFlow中,用户可以通过上传文件、调用API或直接输入文本等多种方式进行数据输入。数据输入后,用户可以通过内置的处理模块对数据进行清洗、转换等操作。最终,处理后的数据将作为模型的输入,得到相应的输出结果。输出结果也可以通过图形化界面展示,用户可以选择将结果导出为文件、发送至API或者直接显示在界面上。

-

调试和优化

在完成工作流设计后,用户可以进入调试模式,对工作流进行测试。LangFlow提供了详细的日志记录功能,用户可以查看每个模块的执行状态和输出结果,帮助调试和排查问题。如果工作流存在性能瓶颈或逻辑错误,开发者可以通过修改模块配置、调整工作流结构等方式进行优化。

-

部署与集成

在完成工作流的构建和调试后,用户可以将整个应用部署到生产环境。LangFlow支持将工作流导出为Docker容器或API服务,方便与现有的业务系统进行集成。用户可以选择合适的部署方式,使得AI应用能够稳定运行并处理生产中的任务。

四、总结

LangFlow作为一款强大的开源工具,极大地简化了语言模型的应用开发流程,其模块化的工作流设计、与多个大语言模型平台的无缝集成、灵活的数据处理能力以及自动化任务调度等特点,使得开发者能够更加高效地构建和管理AI应用。无论是在复杂的企业级应用中,还是在简单的个人项目中,LangFlow都能提供强大的支持。

随着人工智能技术的不断发展,未来LangFlow有望在更多的领域中得到广泛应用,推动AI技术在更多行业中的落地和普及。对于开发者而言,LangFlow不仅是一个高效的开发工具,更是一个开放的平台,提供了无限的可能性和扩展性。对于希望快速实现AI应用的团队来说,LangFlow无疑是一个值得投资和深入了解的优秀开源项目。