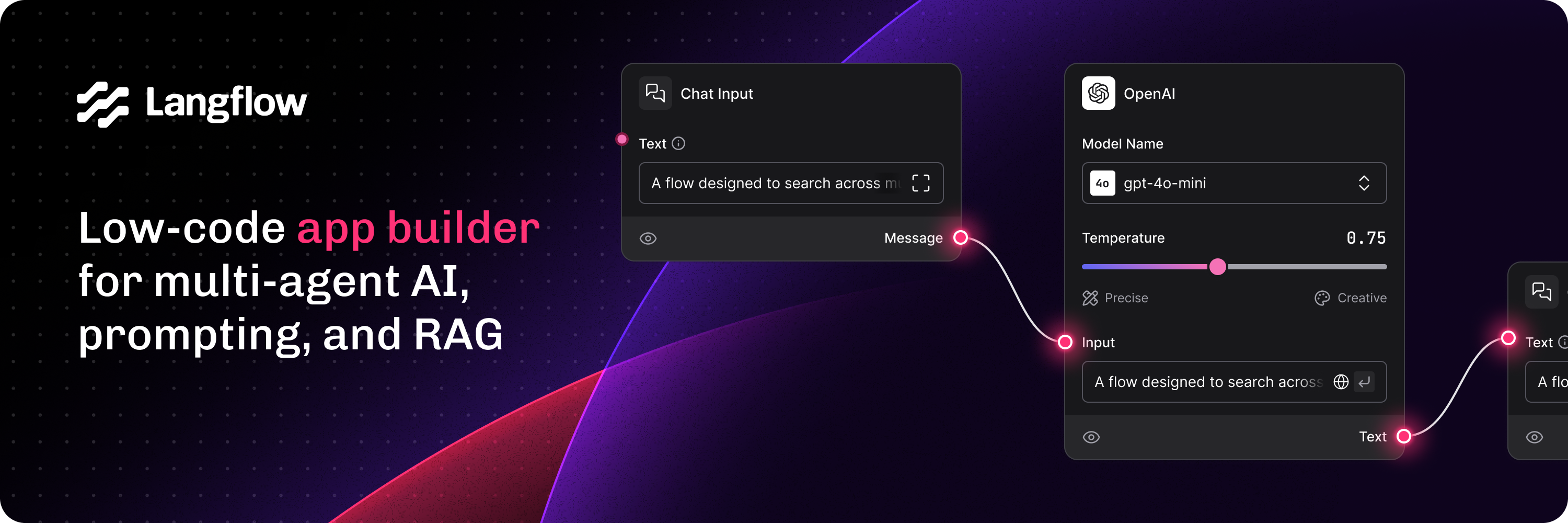

在当今数字化时代,自然语言处理(NLP)技术已经渗透到各个领域,从智能客服到内容推荐,从情感分析到机器翻译。为了简化NLP任务的开发和部署流程,LangFlow应运而生。它是一款专为自然语言处理设计的工作流平台,旨在提供一个高效、灵活且易于使用的环境来构建、训练和部署NLP模型。

LangFlow以其直观的界面和丰富的功能组合,迅速赢得了众多开发者的青睐。接下来我们将深入探讨LangFlow的核心特性及其使用方法,帮助大家更好地理解和应用这一强大的工具。

核心功能

简单易用的Web界面

LangFlow提供了简洁直观的Web界面,使得用户无需具备复杂的编程技能即可轻松管理NLP任务。通过浏览器访问,用户可以方便地创建、编辑和运行各种自然语言处理工作流,并实时查看结果。此外,LangFlow还支持拖拽式操作,进一步降低了使用门槛。

# 启动LangFlow服务

docker run -p 8080:8080 langflow/langflow:latest

支持多种NLP任务

LangFlow内置了对多种常见NLP任务的支持,包括但不限于:

- 文本分类:根据预定义类别对输入文本进行分类。

- 命名实体识别(NER):从文本中提取人名、地名、组织机构等实体信息。

- 情感分析:评估文本的情感倾向(如正面、负面或中性)。

- 机器翻译:将一种语言的文本转换为另一种语言。

- 问答系统:基于知识库或文档生成答案。

这些预置模块让用户能够快速上手,同时也可以根据需求自定义新的任务类型。

{

"tasks": [

{

"type": "text_classification",

"model": "bert-base-uncased",

"labels": ["positive", "negative", "neutral"]

},

{

"type": "ner",

"model": "spacy_en_core_web_sm"

}

]

}

强大的模型管理

为了确保最佳性能,LangFlow集成了丰富的模型管理和优化功能。用户可以从官方仓库下载预训练模型,或者上传自己的模型文件。此外,LangFlow还支持模型版本控制、超参数调优以及在线更新等功能,极大地提升了模型的可维护性和灵活性。

# 下载预训练模型

langflow model download --name bert-base-uncased

# 上传自定义模型

langflow model upload --path ./custom_model.tar.gz

实时协作与共享

LangFlow允许多个用户在同一平台上进行协作,共同完成复杂的NLP项目。每个用户都可以拥有独立的工作空间,并且可以邀请他人加入团队。此外,LangFlow还提供了项目共享功能,用户可以将自己的工作流导出为链接或文件,方便与其他开发者交流和展示成果。

完善的日志与监控

为了帮助用户更好地理解模型表现和系统状态,LangFlow内置了详细的日志记录和实时监控功能。用户可以通过仪表盘查看任务执行进度、资源使用情况以及错误信息等。这种方式不仅有助于问题排查,还能为后续优化提供数据支持。

{

"logs": [

{

"timestamp": "2023-10-01T12:00:00Z",

"level": "INFO",

"message": "Task started successfully"

},

{

"timestamp": "2023-10-01T12:05:00Z",

"level": "ERROR",

"message": "Model failed to load"

}

]

}

丰富的API接口

为了让LangFlow更好地融入现有工作流,它提供了完善的RESTful API接口,涵盖了几乎所有核心功能。通过这些API,用户可以轻松实现与其他系统的集成,例如自动触发任务、获取结果等。此外,LangFlow还支持OAuth2认证,确保API调用的安全性。

{

"api": {

"url": "http://localhost:8080/api/v1",

"token": "your_token"

}

}

安装与配置

环境准备

在开始使用LangFlow之前,我们需要确保计算机上已经安装了必要的依赖项。LangFlow基于Python编写,因此推荐使用官方提供的Docker镜像进行安装。此外,还需要准备好相应的硬件资源(如GPU)以加速模型推理过程。

# 安装Docker

sudo apt-get update

sudo apt-get install docker-ce docker-ce-cli containerd.io

安装步骤

首次启动时,LangFlow会引导用户完成基本配置。用户可以选择默认设置,也可以根据需要自定义参数。根据提示逐步操作即可顺利完成安装过程。

# 启动LangFlow服务

docker run -p 8080:8080 langflow/langflow:latest

数据库配置

为了提高性能和可靠性,建议将LangFlow的数据存储到关系型数据库中。默认情况下,LangFlow使用SQLite作为内置数据库,但如果希望获得更好的扩展性和持久化能力,可以考虑切换到MySQL、PostgreSQL等外部数据库。

[database]

DB_TYPE = postgresql

HOST = 127.0.0.1:5432

NAME = langflow_db

USER = langflow_user

PASSWD = your_password

SMTP配置

为了让LangFlow能够发送邮件通知(如注册确认、密码重置等),需要正确配置SMTP服务器信息。这一步骤对于确保用户体验至关重要。

[mailer]

ENABLED = true

HOST = smtp.example.com:587

FROM = admin@example.com

USER = admin@example.com

PASSWD = your_password

SSL_TLS = true

使用技巧

提升模型性能

在实际应用中,有时会遇到模型性能不够理想的情况。针对这一点,LangFlow提供了一些有效的优化策略。例如,启用批处理模式可以在不影响准确性的前提下加快推理速度;而通过调整模型参数,则可以在保持多样性的同时控制输出的不确定性。

{

"optimization": {

"batch_size": 32,

"max_length": 128,

"temperature": 0.7

}

}

定期备份与恢复

为了防止意外情况导致数据丢失,建议定期进行备份操作。LangFlow提供了便捷的备份和恢复功能,用户只需点击几下按钮即可完成整个过程。同时,还可以设置自动备份计划,确保数据始终处于最新状态。

# 执行备份命令

langflow backup -o /path/to/backup.zip

# 执行恢复命令

langflow restore -f /path/to/backup.zip

集成第三方工具

为了让LangFlow更好地融入现有工作流,它可以与其他常用工具和服务进行集成。例如,通过配置Webhook,可以将LangFlow与持续集成(CI)平台(如Jenkins、Travis CI等)连接起来;而借助OAuth2认证机制,则可以实现与第三方社交平台的单点登录(SSO)。

# 配置OAuth2应用

langflow oauth2 create-app \

--name "github-oauth-app" \

--redirect-uri "http://your-langflow-server/callback" \

--client-id "your_client_id" \

--client-secret "your_client_secret"

总结

综上所述,LangFlow凭借其简洁易用的界面、灵活多样的功能以及出色的性能表现,已经成为了一款备受推崇的自然语言处理工作流平台。无论是在学术研究还是工业应用中,它都能够为我们带来极大的便利。希望本文能够帮助大家更好地了解和掌握LangFlow的使用方法,从而更高效地构建、训练和部署NLP模型。